Что такое информация?

Узнаем понятие информации, какое количество информации генерирует и анализирует современный человек и как она кодируется.

Исследование How Much Information, проведенное в 2009 году показало, что количество потребляемой в неделю информации с 1986 года выросло в 5 раз. С 250 тысяч слов в неделю до 1,25 миллиона! С тех пор это цифра увеличилась в разы. Далее следуют более ошеломительные показатели: в 2018 году кол-во интернет-пользователей и пользователей соц. сетей — 4.021 млрд и 3.196 млрд.

Материю можно изменять и кодировать

Современный человек за день анализирует невероятное количество информации, применяя различные схемы и стратегии по ее обработке, для принятия выгодных для него решений. Человеческий вид сгенерировал 90% информации в этом мире за два последних года. Сейчас, если округлять, в день мы производим порядка 2,5 квинтильонов байт (2,5 * 10^18 байт) новой информации. Если разделить это число на количество живущих сейчас людей, то получится, что в среднем один человек за день создает 0,3 гигабайта информации.

Сколько информации занимают Homo sapiens? (далее Homo). Для простоты в информатике придумали термин под названием бит. Бит – это минимальная единица информации. Файл с этой работой занимает несколько килобайт. Такой документ пятьдесят лет назад занял бы всю память самого мощного компьютера. Средняя книга в цифровом варианте занимает в тысячу раз больше места и это уже мегабайт. Качественное фото на мощный фотоаппарат – 20 мегабайт. Один цифровой диск в 40 раз больше. Интересные масштабы начинаются с гигабайтов.

ДНК человека, вся информация о нас с вами равна около 1,5 гигабайта. Умножаем это на семь миллиардов и получаем 1,05х10^19 байт. В целом, такой объем информации в современных условиях мы можем произвести за 10 дней. Это количество битов опишет всех живущих сейчас людей. И это только данные о самих людях, без взаимодействий между ними, без взаимодействий с природой и культурой, которую человек сам для себя создал. Насколько увеличится эта цифра, если добавлять переменные и неопределенности будущего? Хаос будет подходящим словом.

Информация обладает удивительным свойством. Даже когда ее нет, она есть. И здесь потребуется привести пример. В поведенческой биологии есть знаменитый эксперимент. Друг напротив друга стоит две клетки. В 1-ой обезьяна высокого ранга. Альфа-самец. Во 2-ой клетке обезьяна статусом ниже, бета-самец. Обе обезьяны могут наблюдать за своим визави. Добавим в эксперимент фактор влияния. Между двумя клетками кладем банан. Бета-самец никогда не посмеет взять банан, если знает, что альфа-самец тоже видел этот банан. Потому что он сразу прочувствует всю агрессию альфа-самца. Далее немного изменяют первоначальные условия опыта. Клетку альфа-самца накрывают непрозрачной тканью, чтобы лишить его обзора. Повторяя все то, что сделали до этого картина становится совершенно иной. Бета-самец без каких-либо угрызений совести подходит и берет банан.

Все дело в его умении анализировать, он знает о том, что альфа-самец не видел, как положили банан и для него банана просто не существует. Бета-самец проанализировал факт отсутствия сигнала о появлении банана у альфа-самца и воспользовался ситуацией. Постановка конкретного диагноза пациенту во многих случаях производится при нахождении у него определенных симптомов, однако огромное количество заболеваний, вирусов и бактерий может поставить даже опытного врача в тупик, как ему определить точный диагноз не потратив время, которое может быть жизненно важно для пациента?

Все просто. Он производит анализ не только по тем симптомам, которые есть у больного, но и по тем, которых у него нет, что сокращает время поиска в десятки раз. Если что-то не подает тот или иной сигнал, это тоже несет определенную информацию – как правило, негативного характера, но не всегда. Анализируйте не только информационные сигналы, которые есть, но и те, которых нет.

В связи с перечисленными цифрами и проблемами возникает ряд вопросов и проблем. Как? Как этого удалось достигнуть? Способен ли организм/общество нормально функционировать в таких условиях. Как информация влияет на биологические, экономические и другие виды систем. Объем информации, который мы воспринимаем в 2019 году, покажется мизерным для потомков из 2050. Уже сейчас вид создает новые схемы и паттерны работы с информацией, изучает ее свойства и воздействие. Фраза: — “за год я прожил миллион лет” уже не шутки и не абсурд, а реальность. Количество информации, которое создает человек, влияет на социальную, экономическую, культурную и даже биологическую жизнь.

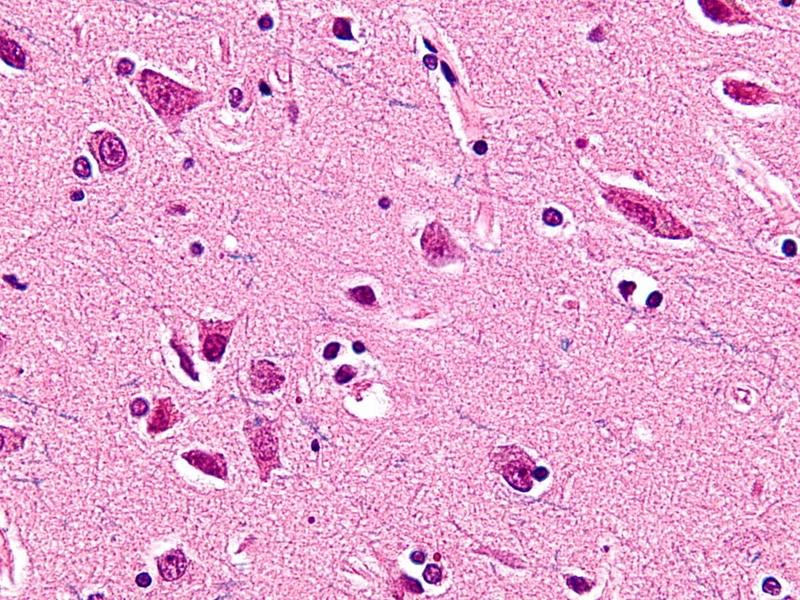

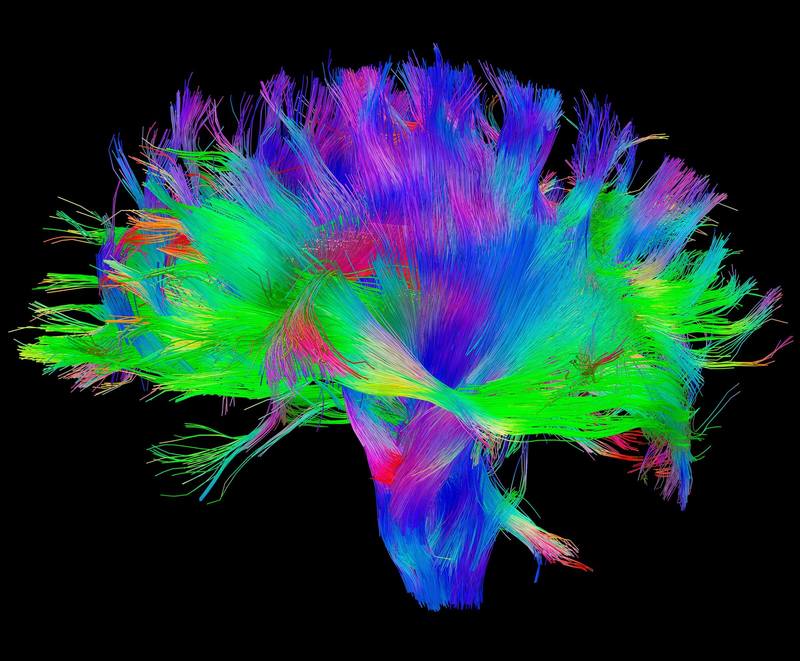

В 1980 года люди мечтали создать квантовый компьютер для увлечения вычислительных мощностей. Это была мечта вида. Открытия, которое сулило это изобретение должны были предвосхитить новую эру. В 2018 году IBM запустила в продажу первый коммерческий квантовый компьютер, но этого уже никто не заметил. Это новость обсуждали невероятно малое количество людей. Она просто утонула в том информационном изобилии, в котором мы сейчас существуем. Основным направлением исследований в последние годы стали нейронауки, алгоритмы, математические модели, искусственный интеллект, что в целом говорит о поиске возможности нормального функционирования в обогащенной информацией среде. Определения закономерностей в передаче информации, факторы ее влияния, свойства и возможности. В 1929 году открыли нейроны фон Экономо, которые встречаются только у высоко социальных групп животных. Есть прямой коррелят размер группы и размер мозга, чем больше группа животных, тем больше у них размер мозга относительно тела. Неудивительно, что нейроны фон Экономо встречаются только у китообразных, слонов и приматов. Нейроны фон Экономо отвечают за передачу больших объемов информации в мозге.

Данный вид нейронов обязательная нейронная адаптация в очень больших мозгах, позволяющая быстро обрабатывать и передавать информацию по очень специфическим проекциям, которая эволюционировала по отношению к новым социальным поведениям. Очевидное присутствие этих специализированных нейронов только у высокоинтеллектуальных млекопитающих может быть примером конвергентной эволюции. Новая информация всегда генерирует новые, качественно другие закономерности и взаимосвязи. Закономерности устанавливаются только на основе информации. Примат бьет камнем по кости убитого буйвола. Один удар и кость разламывается на две части. Еще один удар и еще один разлом. Третий удар и еще несколько осколков. Закономерность ясна. Удар по кости и как минимум один новый осколок. Так ли приматообразные хороши в распознавании закономерностей? Множество половых актов и отложенные роды спустя девять месяцев.

Сколько потребовалось времени, чтобы связать эти два события? Долгое время роды вообще не связывали с половыми актами между мужчиной и женщиной. В большинстве культур и религий за рождение новой жизни отвечали боги. Точная дата открытие этой закономерности, к сожалению, так и не установлена. Однако стоит отметить, что до сих пор существуют закрытые общества охотников собирателей, которые эти процессы не связывают, а за рождение в них отвечают особые ритуалы в исполнении шамана.

Основной причиной детской смертности при родах до 1920 были грязные руки. Чистые руки и не умерший ребенок тоже пример неочевидной закономерности. Вот еще один пример закономерности, которая до 1930 года оставалась неявной. О чем речь? О группах крови. В 1930 году Ландштейнер получил за это открытие нобелевскую премию. До этого момента знание о том, что переливать человеку можно лишь ту группу крови, которая совпадает у донора с нуждающимся было неясным. Подобных примеров миллиарды. Стоит отметить, что поиск закономерностей то, чем вид занимается постоянно. От бизнесмена, который находит закономерность в поведении или потребности людей, а после зарабатывает на этой закономерности долги годы, до серьезных научных исследований, которые позволяют прогнозировать изменение климата, миграцию людей, нахождения мест для добычи полезных ископаемых, цикличности комет, развития эмбриона, эволюции вирусов и как верхушка поведение нейронов в головном мозге. Конечно можно все объяснить устройством вселенной, в которой мы живем и вторым законом термодинамики о том, что энтропия постоянно возрастает, но этот уровень для практических целей не подходит.Следует выбрать более приближенный к жизни. Уровень биологии и информатики.

Что такое информация? Согласно распространённым представлениям, информация – это сведения независимо от формы их представления или решение проблемы неопределённости. В физике информация – это мера упорядоченности системы. В теории информации определение этого термина следующее: информация – это данные, биты, факты или понятия, набор значений. Все эти понятия размыты и неточны, более того, ошибочны.

В доказательства этого выдвинем тезис — информация сама по себе бессмысленна. Что такое число три “3”? Или что такое буква “А”? Просто символ без приписанного значения. Но что такое число “3” в графе группы крови? Это значение, которое спасет жизнь. Оно уже влияет на стратегию поведения. Пример, доведенный до абсурда, но не теряющий своей значимости. Дуглас Адамс написал “Путеводитель для путешествующих автостопом по галактике”. В этой книге созданный квантовый компьютер должен был ответить на главный вопрос жизни и вселенной. В чем смысл жизни и вселенной? Ответ был получен спустя семь с половиной миллионов лет непрерывных вычислений. Компьютер заключил, многократно проверив значение на правильность, что ответ был “42”.

Приведённые примеры дают понять, что информация без внешней среды, в которой она находится (контекста), ничего не значит. Число “2” может означать количество денежных единиц, больных Эболой, счастливых детей или показатель эрудированности человека в каком-то вопросе. Для дальнейшего доказательства прейдем в мир биологии: листья растений очень часто имеют форму полукруга и сперва как бы поднимаются вверх, расширяясь, но после определенной точки преломления тянуться вниз, сужаясь. В ДНК, как в главном носители информации или значений, нет гена, который кодировал бы их такую тягу вниз после определенной точки. То, что лист растения тянется вниз, проделки гравитации.

Сама по себе ДНК, что у растений, что у млекопитающих, что уже у упомянутого Homo Sapiens, несет мало информации, если вообще это делает. Ведь ДНК — это набор значений в определенной среде. ДНК в основном несет факторы транскрипции, то что должно быть активировано определенной внешней средой. Помести ДНК растения/ человека в среду с другой атмосферой или гравитацией, и на выходе получится совсем другой продукт. Поэтому передавать инопланетным формам жизни нашу ДНК для исследовательских целей — довольно глупое занятие. Вполне возможно, в их среде ДНК человека вырастит в нечто даже более ужасающее, чем двуногий прямоходящий примат с оттопыренным большим пальцем и идеями о равенстве.

Информация — это значения/ данные/ биты/ материя в любой форме в непрерывной связи с окружающей средой, системой или контекстом. Информация не существует без факторов внешней среды, системы или контекста. Только в неразрывной связке с этими условиями информация способна передавать смыслы. Говоря языком математики или биологии, информация не существует без внешней среды или систем, на переменные которых она оказывает влияние. Информация всегда является придатком тех обстоятельств, в которых она перемещается. В этой статье будут рассмотрены основные идеи теории информации. Труды интеллектуальной деятельности Клода Шеннона, Ричарда Фейнмана.

Отличительной особенностью вида является способность создавать абстракции и выстраивать закономерности. Представлять одни явления, через другие. Мы кодируем. Фотоны на сетчатке глаза создают картинки, колебания воздуха преобразовываются в звуки. Определенный звук мы связываем с определенной картинкой. Химический элемент в воздухе, своими рецепторами в носу мы интерпретируем, как запах. Через рисунки, картинки, иероглифы, звуки мы можем связывать события и передавать информацию.

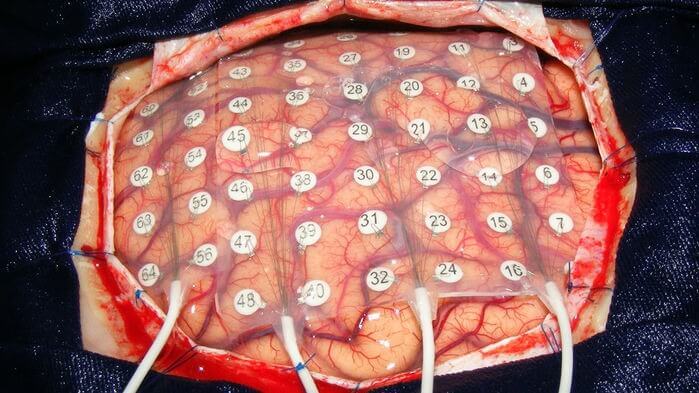

Подобное кодирование и абстракции не стоит недооценивать, достаточно только вспомнить насколько сильно оно влияет на людей. Кодировки способны одержать верх над биологическими программами, человек ради идеи (картинки в голове, которая определяет стратегию поведения) отказывается от передачи копий своих генов дальше или вспомнить всю мощь физических формул, позволивших отправить представителя вида в космос, химических уравнений, которые помогают лечить людей и так далее. Более того мы можем кодировать то, что уже закодировано. Простейшим примером может послужить перевод с одного языка на другой. Один код представляется в форме другого. Простота трансформации, как главный фактор успешности этого процесса позволяет делать его бесконечным. Можно перевести выражение с японского на русский, с русского на испанский, с испанского на двоичную систему, с нее в азбуку Морзе, после представить это в виде языка Брайля, потом в форме компьютерного кода, а после в виде электрических импульсов пустить это прямо в мозг, где он декодирует сообщение. Совсем недавно сделали обратный процесс и декодировали активность мозга в речь.

В период от сорока до двадцати тысяч лет назад первобытные люди начали активно кодировать информацию в виде речевых или жестовых кодов, наскальных живописей. Современные люди, наблюдая первые наскальные рисунки, пытаются определить (декодировать) их смысл, поиск смыслов — это еще одна отличительная черта вида. Воссоздавая контекст по определённым маркерам или остаткам информации, современные антропологи пытаются понять быт первобытных людей. Квинтэссенция процесса кодирования воплотилась в виде письменности. Письменность разрешила проблему потери информации при ее передаче не только в пространстве, но и во времени. Иероглифы цифр позволяют кодировать вычисления, слова предметы и т.д.

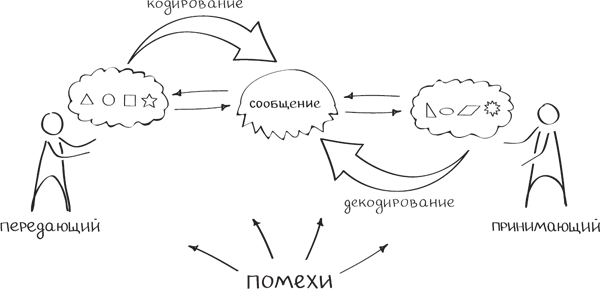

Однако, если с точностью проблема решена более-менее эффективно, если конечно же оба участника процесса коммуникации используют одинаковые условные соглашения на трактовку и процесс декодирования одних и тех же символов, иероглифов, то со временем и скоростью передачи печатная письменность потерпела неудачу. Для решения проблемы скорости были изобретены системы радио и телекоммуникаций.Ключевым этапом развития передачи информации можно считать две идеи. Первая — цифровые каналы связи, а вторая — развитие математического аппарата. Цифровые каналы связи решили проблему в скорости передачи информации, а математический аппарат в его точности.

Любой канал имеет определенный уровень шумов и помех, благодаря которым информация приходит с помехами (набор значений и иероглифов искажен, теряется контекст) или вообще не приходит. По мере развития технологий количество шумов в цифровых каналах связи уменьшалось, но никогда не сводилось к нулю, а по мере увеличения расстояния вообще увеличивалось.Ключевая проблема, которую необходимо решить при потере информации в цифровых каналах связи, была обозначена и решена Клодом Шенноном в 1948 году, а также придуман термин бит. Звучит она следующим образом: — “Пусть источник сообщений имеет энтропию (Н) на одну секунду, а (С) — пропускная способность канала. Если H<С или Н=С, то возможно такое кодирование информации, при котором данные источника будут переданы через канал со сколь угодно малым количеством ошибок”.

Данная формулировка проблемы является причиной бурного развития науки под названием — теория информации. Основные проблемы, которые она решает и пробует решить, сводятся к тому, что цифровые каналы, как уже упоминалось выше, имеют шумы или сформулированы следующим образом – “ отсутствует абсолютная надежность канала в передачи информации». Т.е. информация может теряется, искажается, наполнятся ошибками из-за воздействия окружающей среды на канал передачи информации. Клод Шеннон выдвинул ряд тезисов, из которых следует, что возможность передачи информации без потерь и изменений в ней, т.е. с абсолютной точностью, существует в большинстве каналов с шумами. По сути он разрешил Homo Sapiens не тратить усилия на улучшение каналов коммуникации. Вместо этого он предложил разрабатывать более эффективные схемы кодирования и декодирования информации. Представлять информацию в виде 0 и 1.

Идею можно расширить до математических абстракций или языкового кодирования. Продемонстрировать эффективность идеи можно на примере. Ученый наблюдает за поведением кварков на адронном коллайдере, свои данные он заносит в таблицу и анализирует, выводит закономерность в виде формул, формулирует основные тенденции в виде уравнений или записывает в виде математических моделей, факторы, влияющие на поведение кварков. Ему необходимо передать эти данные без потерь. Перед ним встает ряд вопросов. Цифровой канал связи использовать или передать через своего помощника или позвонить и лично все рассказать? Время остается критически мало, а передать информацию необходимо срочно, поэтому электронная почта отметается. Помощник — абсолютно ненадежный канал связи с вероятностью возникновения шумов близкой к бесконечности. В качестве канала связи он выбирает позвонить.

Насколько точно он сможет воспроизвести данные таблицы? Если в таблице одна строка и два столбца, то довольно точно. А если там десять тысяч строк и пятьдесят столбцов? Вместо этого он передает закономерность, закодированную в виде формулы. Если бы он был в ситуации, когда может передать таблицу без потерь и был уверен, что другой участник процесса коммуникации придет к тем же закономерностям, а также время не являлось бы фактором, оказывающим влияние, то вопрос был бы лишен смысла. Однако, выведенная в качестве формулы закономерность, уменьшает количество времени на декодирование, меньше подвержена трансформациям и шумам при передаче информации. Примеров подобных кодировок по ходу данной работы будет приведено многократное количество раз. Каналом связи можно считать диск, человека, бумагу, спутниковая антенну, телефон, кабель, по которому протекает сигналы, и так далее. Кодировка не только устраняет проблему потери информации, но и проблему ее объемов.

С помощью кодирования можно сокращать размерность, уменьшать количество информации. После прочтения книги вероятность пересказать книгу без потерь информации стремится к нулю, при отсутствии синдрома Саванта. Закодировав или сформулировав основную идею книги в форме определенного высказывания, мы представляем ее краткий обзор. Основная задача кодирования заключается в укороченном формулировании исходного сигнала без потери информации для его передачи на большое расстояние вне времени другому участнику коммуникации таким образом, что участник смог его эффективно декодировать. Веб-страница, формула, уравнение, текстовый файл, цифровое изображение, оцифрованная музыка, видеоизображение — это все яркие примеры кодировок.

Проблемы точности передачи, расстояния, времени, процесса кодирования были решены в той или иной степени и это позволило создавать информации в разы больше, чем человек способен воспринять, находить закономерности, которые будут еще долгое время незамеченными. Появился ряд других проблем. Где хранить такой объем информации? Как хранить? Современное кодирование и математический аппарат, как оказалось не совсем решает проблемы с хранением. Есть предел укорачивания информации и предел ее кодировки, после которой декодировать значения обратно не представляется возможным. Как было уже упомянуто выше, набор значений без контекста или внешней среды информации уже не несет. Можно, однако кодировать по отдельности информацию о внешней среде и наборе значений, а после совмещать в форме определенных индексов и декодировать сами индексы, однако первоначальные значения о наборе значений и внешней среде все равно нужно где-то хранить. Были предложены замечательные идеи, которые и сейчас используются повсеместно.

Забегая вперед, можно привести пример того, что не обязательно описывать всю внешнюю среду, можно формулировать только условия ее существования в виде законов и формул. Что такое наука? Наука – это высшая степень мимикрии над природой. Научные достижения – это абстрактное воплощение реально существующих явлений. Одно из решений проблемы хранения информации было изящно описано в очаровательной статье Ричарда Фейнмана “Там внизу полным-полно места: приглашение в новый мир физики”. Эта статья иногда считается тем трудом, который положил начало развитием нано технологиям. В ней ученый-физик предлагает обратить внимание на удивительное особенности биологических систем, как хранилищ информации. В миниатюрных, крошечных системах заключено невероятно много данных о поведении — то как они хранят и используют информацию, ничего кроме восхищения вызвать не может.

Если говорить о том, насколько много могут хранить информации биологические системы, то журнал Nature произвел оценку, что всю информацию, значения, данные и закономерности мира возможно записать в ДНК-хранилище весом до одного килограмма. Вот и весь вклад во вселенную, один килограмм материи. ДНК чрезвычайно эффективная структура по части хранения информации, которая позволяет хранить и использовать наборы значений в огромных объемах. Если кому-то интересно, то вот статья, которая рассказывает, как записать в ДНК-хранилище фотографии котов и вообще любую информацию, даже песни Скриптонита (крайне глупое использование ДНК).

Фейнман обращает внимание на то, какое количество информации закодировано в биологических системах, что в процессе существования они не только кодируют информацию, но и меняют структуру материи на основе этого. Если до этого момента все предложенные идеи основывались только на кодировки набора значений или информации, как таковой, то после этой статьи вопрос стоял уже в кодировки внешней среды в пределах отдельных молекул. Кодировать и изменять материю на уровне атомов, заключать в них информацию и так далее. Например, он предлагает создавать соединительные провода диаметром в несколько атомов. Это в свою очередь позволит увеличить количество составных частей ЭВМ в миллионы раз, подобное увеличение элементов качественно улучшит вычислительные мощности будущих разумных машин.Фейнман, как создатель квантовой электродинамики и человек участвовавший в разработке атомной бомбы прекрасно понимал, что кодировка материи не является чем-то фантастическим, а представляется нормальным процессом в наблюдаемой реальности.

Он даже делает акцент на том, что физика не запрещает создавать объекты атом за атомом. В статье он так же прибегает к сравнению деятельности человека и машины, обращая внимание на тот факт, что любой представитель вида без труда распознает лица людей в отличии от ЭВМ для которых в то время это была задача за пределами вычислительных мощностей. Задает ряд важных вопросов от “что мешает создать сверхмалую копию чего-либо?” до “отличие ЭВМ от человеческого мозга только в количестве составных элементов?”, так же он описывает механизмы и основные проблемы при создании чего-либо атомного размера.

Современники оценили количество нейронов мозга в примерно 86 миллиардов, естественно, что ни одна ЭВМ ни тогда, не сейчас к этому значению не приблизилась, как оказалось это и не нужно. Однако, работа Ричарда Фейнмана начала двигать идею о информации в сторону уменьшения, туда где много места. Статья вышла в 1960 году, уже после появления работы Алана Тьюринга “Вычислительные машины и разум” одной из самых цитируемых работ вида. Поэтому сравнение деятельности человека и ЭВМ было трендом, которое отразилось и в статье Ричарда Фейнмана.

Благодаря непосредственному вкладу ученого физика стоимость хранения данных с каждым годом падает, облачные технологии развиваются сумасшедшими темпами, создан квантовый компьютер, мы записываем данные в ДНК-хранилища и занимаемся генной инженерией, что еще раз доказывает, что материю можно изменять и кодировать. опубликовано econet.ru

Подписывайтесь на наш канал Яндекс Дзен!

Если у вас возникли вопросы по этой теме, задайте их специалистам и читателям нашего проекта здесь.

P.S. И помните, всего лишь изменяя свое потребление - мы вместе изменяем мир! © econet

Источник: https://econet.ru./

Понравилась статья? Напишите свое мнение в комментариях.

Добавить комментарий