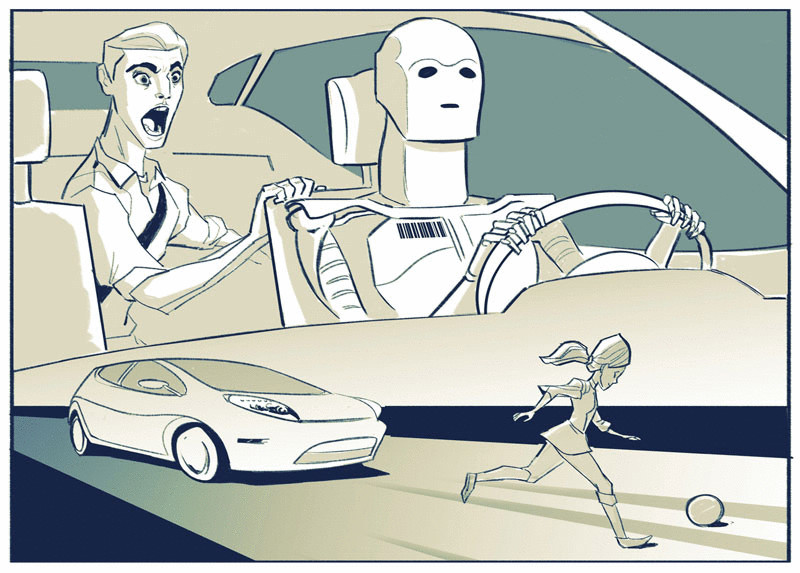

Можем ли доверить роботизированным автомобилям принятие нелегких решений

Экология жизни: В последнее время этические вопросы в отношении роботизированной техники возникают все чаще. В частности, если робот-автомобиль окажется в ситуации, когда столкновение неизбежно и он должен выбирать, кого сбить – одного человека или другого, каков будет его выбор

В последнее время этические вопросы в отношении роботизированной техники возникают все чаще. В частности, если робот-автомобиль окажется в ситуации, когда столкновение неизбежно и он должен выбирать, кого сбить – одного человека или другого, каков будет его выбор и на основе чего он его сделает? Это современный вариант проблемы выбора, которую многие разбирали на вводном курсе философии в университете.

Представьте себе, что роботизированный автомобиль движется по дороге и ему навстречу выбегают два человека, причем избежать столкновения с обоими не представляется возможным. Предположим, человек не может уйти с дороги, а автомобиль – вовремя свернуть. Вот, собственно, варианты, которые предложили опрошенные люди:

- в роботе-автомобиле может быть код, чтобы принять случайное решение.

- робот-автомобиль может передавать управление человеку-пассажиру.

- робот-автомобиль может принять решение на основе набора заранее запрограммированных разработчиками показателей или на основе набора показателей, запрограммированных владельцем автомобиля.

Последний из этих вариантов заслуживает более подробного рассмотрения. Итак, какие бы это могли быть показатели?

КАК РОБОТИЗИРОВАННЫЕ АВТОМОБИЛИ БУДУТ ПРИНИМАТЬ ЭТИЧЕСКИЕ РЕШЕНИЯ?

Например, владелец может установить следующую настройку: в случае выбора между взрослым и ребенком сбить взрослого. Автомобиль может даже попытаться вычислить значимость одной и другой жизней, используя для этого системы распознавания. То есть, если в первом человеке, который может быть сбит, автомобиль узнает преступника, а во втором – ученого, работающего над изобретением лекарства от рака, то машина совершит наезд на первого.

В каждом из этих примеров, однако, компьютер оставляет решение на волю случая, давая возможность принять его кому-то другому.

Люди делают то же самое: когда они сталкиваются с решениями, то подкидывают монетку, просят совета других или ориентируются на мнения авторитетов в попытке найти нужный ответ.

Тем не менее, сталкиваясь с ситуациями, которые требуют принятия жестких решений, мы также поступаем иначе. В частности, в неоднозначных моментах, когда очевидного выбора нет, мы выбираем и оправдываем наше решение логическими причинами. Правда, мир полон таких жестких решений; при этом то, как роботизированные автомобили (или роботы в целом) будут справляться с такого рода выбором, будет иметь решающее значение для их разработки и принятия обществом.

Чтобы выяснить, как машины могут принимать эти трудные решения, нужно изучить, как их принимают люди. Это хорошая идея. Доктор Рут Чанг утверждает: жесткие решения определяются тем, как альтернативные варианты связаны друг с другом.

При принятии легких решений, например, одна альтернатива явно лучше, чем другая. Если мы предпочитаем натуральные цвета искусственным, то нам легко выбрать цвет, например, для покраски стен комнаты – мы наверняка предпочтем спокойный бежевый люминесцентному розовому. В случае с принятием жестких решений в пользу каждого выбора есть свои аргументы. Но в целом ни один, ни другой идеальными не являются.

Возможно, нам придется выбирать между тем, чтобы принять предложение о работе в сельской местности или тем, чтобы остаться на нашей текущей должности в городе. Возможно, мы в равной степени ценим жизнь в городе и хотели бы получить новую работу. Таким образом, обе альтернативы равны. В этом случае, чтобы принять важное решение, мы должны переосмыслить наши исходные ценности и показатели: что на самом деле для нас важнее? Жизнь в городе или новая работа?

ПРИ ПРИНЯТИИ ТРУДНЫХ РЕШЕНИЙ ВАРИАНТЫ ВЫБОРА СЛОЖНО СРАВНИВАТЬ

Важно отметить: когда мы приняли решение, нужно оправдать его причины.

Если мы предпочитаем бежевые или флуоресцентные цвета, сельскую местность или определенную профессиональную деятельность, эти предпочтения нельзя измерить, то есть нельзя сказать что одно «более правильное», чем другое. Нет объективной причины говорить, к примеру, что бежевый лучше ярко-розового, и что жить в сельской местности лучше. Если были бы причины, определяющие объективно, что одно лучше другого, то все люди делали ли бы одинаковый выбор. Вместо этого каждый из нас придумывает причины, по которым принимает свои решения (и когда в обществе мы делаем все это вместе, то создаем наши законы, социальные нормы и этические системы).

Но машина никогда не сможет сделать этого... не так ли? Вы будете удивлены. Недавно компания Google объявила, что, например, был создан искусственный интеллект, который может учиться и добиться успехов в видеоиграх. Программа не получает команд, но вместо этого снова и снова играет, получая опыт и делая выводы. Некоторые полагают, что такой навык был бы особенно полезно для роботизированных автомобилей.

КАК ЭТО МОЖЕТ РАБОТАТЬ?

Вместо того чтобы роботизированные автомобили принимали случайные решения (с помощью внешних команд или используя для этого предварительно запрограммированные ценности и показатели), современные роботы могут использовать множество данных, которые будут храниться для них в облаке, что даст им возможность при принятии решения учитывать местные законы, последние юридические постановления, людей и общество, а также последствия, к которым со временем приведут те или иные решения.

Короче говоря, роботизированные автомобили, как и люди, должны использовать опыт, чтобы генерировать свои собственные причины для принятых решений.

Самое интересное, рассказывает Чанг, что в тяжелые времена люди занимаются процессом, который можно условно назвать «придумывание оправданий». То есть речь идет о том, что люди придумывают и выбирают причины, которые оправдывают их выбор, и мы рассматриваем это как одну из самых высоких форм развития человека.

Когда мы перекладываем принятие решений на других или отдаем ситуацию на волю случая – это своеобразный способ «плыть по течению». Но определение и выбор причин, по которым мы принимаем решения в тяжелые времена, зависят также от характера человека, занятой им позиции, способности нести ответственность за свои действия; все это определяет, кто вы есть, и дает возможность самому быть автором своей же жизни.

КРОМЕ ТОГО, ПРИ ПРИНЯТИИ РЕШЕНИЙ МЫ ТАКЖЕ РАССЧИТЫВАЕМ НА ДРУГИХ ЛЮДЕЙ

Никто в здравом смысле не доверил бы свою жизнь, благополучие или деньги человеку, который принимает случайные решения, просит, чтобы другие решали все за него, когда ситуация становится жесткой, или тем, кто в жизни «плывет по течению».

Мы доверяем принятие решений другим, когда знаем об их ценностях и знаем, что они будут принимать решение в соответствии с этими ценностями. Чтобы мы доверяли серьезный выбор технике, мы должны быть уверены, что она также будет руководствоваться схожими принципами.

К сожалению, широкая общественность далека от понимания того, как искусственный интеллект принимает решения. Возможно, создатели роботизированных автомобилей, беспилотных летательных аппаратов и других умных машин могут держать эту информацию в секрете либо из-за опасений безопасности их интеллектуальной собственности, либо по соображениям безопасности как таковой. А сегодня многие считают, что искусственному разуму нельзя доверять и боятся доверить таким машинам принятие сколько-нибудь важных решений.

И здесь мы должны вернуться к мнению и выводам Чанга. По мере того как мы все больше приближаемся к эре, когда нас станут окружать роботизированные автомобили, в наших домах будут роботы, а БПЛА получат одобрение правоохранительных органов и вооруженных сил, мы должны будем уже не просто плыть по течению. Общество должно разобраться в том, как роботы принимают решения, а компании и правительство должны сделать техническую информацию более доступной и понятной для широкого круга потенциальных пользователей таких устройств.

В некоторых случаях, как мы уже заметили, роботы могут принимать более обоснованные решения, чем люди. По крайней мере, на данный момент роботизированные автомобили показывают себя более результативно, чем люди-водители — в апреле прошлого года средний показатель составлял 700000 миль без аварий (сейчас больше). При быстрой смене внешних обстоятельств люди не всегда могут быстро и адекватно среагировать и часто следуют инстинктам, которые далеко не каждый раз оказываются верными.

И НАМ ВСЕ РАВНО ПРИХОДИТСЯ ПРИНИМАТЬ ВСЕ БОЛЕЕ СЛОЖНЫЕ РЕШЕНИЯ

В мире, где искусственный интеллект может думать, но не обязательно будет обращать внимание на то, накажут его или похвалят за принятое решение, мы должны разработать новые механизмы — вне нашей нынешней системы правосудия и наказания, которую мы сегодня применяем к обществу людей, чтобы сохранить мир. И если есть большая разница между людьми и искусственным интеллектом, то, каким образом мы будет соблюдать законы и интерпретировать их для механических собратьев, становится все более важным.

Сталкиваясь с необходимостью принятия таких трудных решений, мы должны делать нечто большее, чем просто плыть по течению. Мы должны решить, что является самым важным для нас и как мы будем хозяевами своей собственной жизни в мире, который придется делить с роботами. Возможно, вопрос не в том, могут ли роботы принимать сложные решения, а в том, могут ли такие решения принимать люди.

Источник: https://econet.ru./

Понравилась статья? Напишите свое мнение в комментариях.

Добавить комментарий